W świecie SEO, gdzie każdy detal ma znaczenie dla widoczności strony, problem duplikacji treści jest jednym z tych, które często bywają niedoceniane, a mogą mieć poważne konsekwencje. Identyczne lub bardzo podobne fragmenty tekstu, dostępne pod różnymi adresami URL, potrafią skutecznie utrudnić wyszukiwarkom zrozumienie, która wersja jest tą najważniejszą. To z kolei prowadzi do rozproszenia autorytetu, kanibalizacji słów kluczowych i w efekcie spadku pozycji w wynikach wyszukiwania. W tym artykule, jako Cyprian Szymczak, przeprowadzę Cię przez praktyczny przewodnik, który wyposaży Cię w metody i narzędzia do samodzielnego wykrywania i eliminowania duplikatów, zarówno tych wewnętrznych, jak i zewnętrznych.

Jak skutecznie sprawdzić duplicate content praktyczny przewodnik po metodach i narzędziach

- Duplikacja treści to identyczne lub bardzo podobne fragmenty tekstu pod różnymi adresami URL, dzieląca się na wewnętrzną (w obrębie domeny) i zewnętrzną (między domenami).

- Problem ten negatywnie wpływa na SEO, utrudniając Google wybór kanonicznej wersji strony, rozpraszając autorytet linków i marnując budżet na indeksowanie.

- Do sprawdzenia duplikatów wykorzystaj proste operatory Google (`site:`, `""`) lub specjalistyczne narzędzia, takie jak Google Search Console, Screaming Frog, Copyscape czy Siteliner.

- Skuteczne rozwiązania obejmują przekierowania 301, tag kanoniczny `rel="canonical"` oraz meta tag `noindex`, które pomagają wskazać wyszukiwarkom preferowaną wersję treści.

- Kluczem do długoterminowego sukcesu jest prewencja, czyli tworzenie unikalnych treści i regularny monitoring, aby unikać powstawania duplikatów.

Duplicate content: Dlaczego powielone treści szkodzą Twojemu SEO?

Zacznijmy od podstaw. Czym właściwie jest duplicate content? Mówiąc najprościej, to sytuacja, w której identyczna lub bardzo podobna treść jest dostępna pod wieloma różnymi adresami URL. Nie chodzi tu tylko o dosłowne kopiuj-wklej, ale także o fragmenty tekstu, które różnią się tylko nieznacznie, np. kolejnością słów czy drobnymi zmianami stylistycznymi. Dla wyszukiwarek, takich jak Google, jest to sygnał, że mają do czynienia z tym samym przekazem, co rodzi szereg problemów.

Duplikację treści możemy podzielić na dwa główne typy. Pierwszy to duplikacja wewnętrzna, która występuje w obrębie jednej domeny. Jej przyczyny są często techniczne i niezamierzone. Mogą to być na przykład różne wersje protokołu (HTTP i HTTPS), adresy z "www" i bez "www", parametry w URL-ach generowane przez filtry, sortowanie czy paginację, a także wersje strony przeznaczone do druku. Drugi typ to duplikacja zewnętrzna, czyli powielanie treści między różnymi domenami. Może ona wynikać z kradzieży treści (plagiatu), syndykacji (publikowania tego samego artykułu na wielu stronach za zgodą autora) lub, co bardzo częste w e-commerce, z kopiowania opisów produktów dostarczanych przez producentów.

Wiele osób obawia się, że Google karze za duplicate content. W rzeczywistości, zazwyczaj nie jest to bezpośrednia kara, chyba że mamy do czynienia z celową manipulacją i próbą oszukania algorytmów. Problem polega na tym, że duplikacja wprowadza wyszukiwarki w zakłopotanie. Google ma trudność z wyborem, która wersja strony jest tą "kanoniczną", czyli oryginalną i najważniejszą, którą powinno wyświetlać w wynikach. To prowadzi do kilku negatywnych konsekwencji: rozproszenia autorytetu linków (link equity), kanibalizacji słów kluczowych (dwie strony konkurują o to samo zapytanie), marnowania budżetu na indeksowanie (crawl budget) oraz w efekcie obniżenia widoczności strony w wynikach wyszukiwania. W mojej praktyce widziałem wiele przypadków, gdzie uporządkowanie duplikatów przyniosło znaczną poprawę pozycji.

Problem duplikacji treści może dotyczyć nawet 29% wszystkich stron w internecie. W przypadku sklepów internetowych odsetek ten bywa znacznie wyższy z powodu wariantów produktów, filtrów i kopiowania opisów.

Audyt krok po kroku: Jak samodzielnie sprawdzić duplicate content?

Zanim sięgniemy po zaawansowane narzędzia, warto poznać proste, ale skuteczne metody ręcznego sprawdzania duplikatów. Wiele problemów można zdiagnozować, korzystając jedynie z wyszukiwarki Google.

Wyszukiwanie duplikatów wewnętrznych za pomocą operatora `site:`

Operator `site:` to potężne narzędzie, które pozwala ograniczyć wyniki wyszukiwania do konkretnej domeny. W połączeniu z cudzysłowem, możesz w ten sposób sprawdzić, czy dany fragment tekstu pojawia się wielokrotnie w obrębie Twojej witryny.

- Wejdź na swoją stronę internetową i znajdź fragment tekstu (np. jedno lub dwa zdania), który chcesz sprawdzić.

- Skopiuj ten fragment tekstu. Upewnij się, że jest on na tyle unikalny, by nie był to ogólny frazes.

- Otwórz wyszukiwarkę Google.

- Wpisz w pasku wyszukiwania:

site:twojadomena.pl "skopiowany fragment tekstu". Pamiętaj, aby w miejscetwojadomena.plwpisać adres swojej witryny, a skopiowany tekst umieścić w cudzysłowie. - Naciśnij Enter.

Przykład: Jeśli masz stronę o adresie mojafirma.pl i chcesz sprawdzić, czy zdanie "Nasza firma oferuje kompleksowe rozwiązania dla biznesu" pojawia się gdzieś indziej na Twojej stronie, wpiszesz: site:mojafirma.pl "Nasza firma oferuje kompleksowe rozwiązania dla biznesu". Jeśli Google zwróci więcej niż jeden wynik, masz do czynienia z duplikacją wewnętrzną.

Wykrywanie duplikatów zewnętrznych (plagiatu) z użyciem cudzysłowu

Ta metoda jest idealna do sprawdzenia, czy Twoja treść nie została skopiowana przez inne strony w internecie, lub czy Ty sam nie powieliłeś treści z innych źródeł.

- Wybierz unikalny fragment tekstu (najlepiej 1-2 zdania) ze swojej strony, który chcesz sprawdzić pod kątem plagiatu.

- Skopiuj ten fragment tekstu.

- Otwórz wyszukiwarkę Google.

- Wklej skopiowany fragment tekstu w cudzysłowie (

"skopiowany fragment tekstu") do paska wyszukiwania. - Naciśnij Enter.

Przykład: Jeśli chcesz sprawdzić, czy zdanie "Inwestowanie w nieruchomości to sprawdzony sposób na pomnażanie kapitału" z Twojego bloga nie pojawia się na innych stronach, wpiszesz: "Inwestowanie w nieruchomości to sprawdzony sposób na pomnażanie kapitału". Wyniki pokażą wszystkie strony, na których Google znalazło dokładnie ten sam fragment tekstu. Jeśli Twoja strona nie jest pierwsza na liście, może to oznaczać, że ktoś skopiował Twoją treść, lub Ty skopiowałeś ją od kogoś.

Profesjonalne narzędzia do wykrywania duplikatów: Twój niezbędnik SEO

Ręczne sprawdzanie jest dobre na początek, ale przy większych witrynach staje się niewykonalne. Na szczęście, istnieje wiele profesjonalnych narzędzi, które automatyzują proces wykrywania duplikatów.

Google Search Console Twój darmowy punkt wyjścia

Google Search Console(GSC) to absolutna podstawa dla każdego właściciela strony. Jest to darmowe narzędzie od Google, które dostarcza bezcennych informacji o tym, jak wyszukiwarka widzi Twoją witrynę. W kontekście duplikatów, GSC może wskazać Ci strony, które Google uznaje za duplikaty, a Ty nie wskazałeś dla nich wersji kanonicznej. Znajdziesz te informacje w raporcie "Indeksowanie" -> "Strony", gdzie pojawią się statusy takie jak "Duplikat, użytkownik nie oznaczył strony kanonicznej". To pierwszy sygnał, że masz problem do rozwiązania.

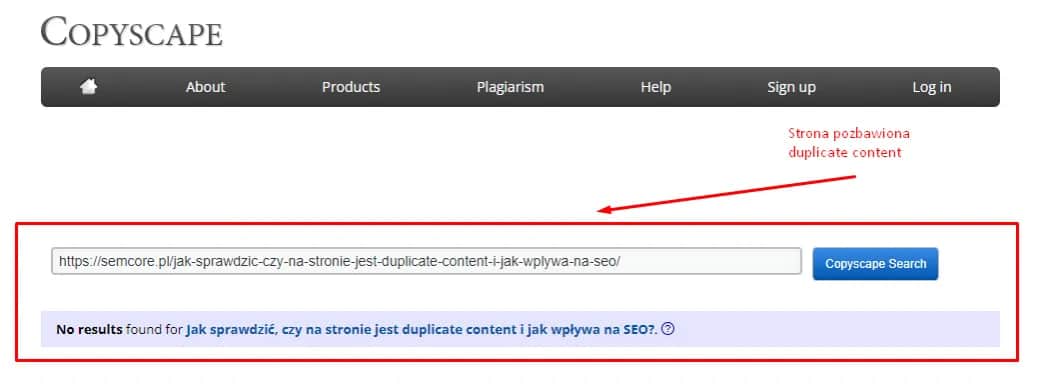

Copyscape i Siteliner specjaliści od duplikacji

Copyscape to narzędzie, które stało się standardem w branży, jeśli chodzi o wykrywanie duplikacji zewnętrznej, czyli plagiatu. W darmowej wersji pozwala na sprawdzenie pojedynczych adresów URL pod kątem ich powielenia w internecie. Wersja premium oferuje znacznie więcej funkcji, w tym możliwość skanowania całej witryny i otrzymywania alertów o nowych duplikatach. To narzędzie jest niezastąpione, jeśli chcesz chronić swoją oryginalną treść przed kradzieżą lub upewnić się, że treści, które publikujesz, są unikalne.

Z kolei Siteliner to doskonałe narzędzie do analizy duplikacji wewnętrznej. Skanuje ono całą Twoją stronę i pokazuje procentowo, ile treści jest powielonych na poszczególnych podstronach. Generuje raporty, które jasno wskazują, które URL-e zawierają zduplikowaną treść, a także wskazuje na inne problemy, takie jak uszkodzone linki czy brakujące strony. Jest to bardzo intuicyjne narzędzie, które pozwala szybko zidentyfikować obszary wymagające optymalizacji.

Screaming Frog SEO Spider głęboka analiza techniczna

Screaming Frog SEO Spider to desktopowy crawler, który w mojej pracy jest jednym z najczęściej używanych narzędzi do dogłębnej analizy technicznej stron internetowych. Pozwala on na przeskanowanie całej witryny i zebranie ogromnej ilości danych, w tym tych dotyczących duplikatów. Screaming Frog potrafi wykrywać zarówno dokładne duplikaty (exact duplicates), jak i treści niemal identyczne (near duplicates), bazując na progu podobieństwa, który domyślnie wynosi 90%. To niezwykle przydatne, gdy chcemy znaleźć strony, które różnią się tylko drobnymi elementami, ale dla Google są wciąż tym samym.

- Wykrywanie stron z identycznymi tytułami, meta opisami i nagłówkami H1.

- Identyfikacja duplikatów treści na podstawie haszy MD5.

- Raportowanie treści niemal identycznych (near duplicates) z możliwością konfiguracji progu podobieństwa.

- Wskazywanie problemów z paginacją i parametrami URL.

Inne narzędzia warte uwagi

Rynek oferuje wiele innych narzędzi, które mogą być pomocne w walce z duplikatami:

- Duplichecker: Darmowe narzędzie online do sprawdzania plagiatu, podobne do Copyscape, ale z własnymi algorytmami.

- Plagiarism Checker od Small SEO Tools: Kolejne darmowe narzędzie do sprawdzania unikalności tekstu, często używane przez twórców treści.

- Sitebulb: Płatny crawler, który oferuje bardzo zaawansowane raporty dotyczące duplikacji treści, w tym wizualizacje problemów.

- Ahrefs Site Audit: Moduł w pakiecie Ahrefs, który skanuje witrynę pod kątem wielu problemów SEO, w tym duplikatów treści, wskazując konkretne URL-e i sugerując rozwiązania.

Najczęstsze pułapki i źródła duplikacji: Sprawdź, czy nie popełniasz tych błędów

Z mojego doświadczenia wynika, że wiele problemów z duplikacją treści wynika z powtarzających się błędów lub niedopatrzeń. Warto je znać, aby świadomie ich unikać.

E-commerce: Warianty produktów i opisy od producentów

Sklepy internetowe są szczególnie narażone na problem duplikacji. Jednym z głównych winowajców są opisy produktów kopiowane bezpośrednio od producentów. Jeśli sprzedajesz popularne produkty, istnieje duża szansa, że setki innych sklepów używają dokładnie tych samych opisów. Dla Google jest to sygnał, że Twoja strona nie wnosi unikalnej wartości. Innym źródłem duplikatów są warianty produktów (np. ten sam T-shirt w różnych kolorach lub rozmiarach), które często mają niemal identyczne opisy i są dostępne pod różnymi URL-ami. Dodatkowo, strony generowane przez filtry i sortowanie (np. "buty damskie > czerwone > rozmiar 38") mogą tworzyć setki, a nawet tysiące zduplikowanych URL-i, które Google może próbować indeksować.

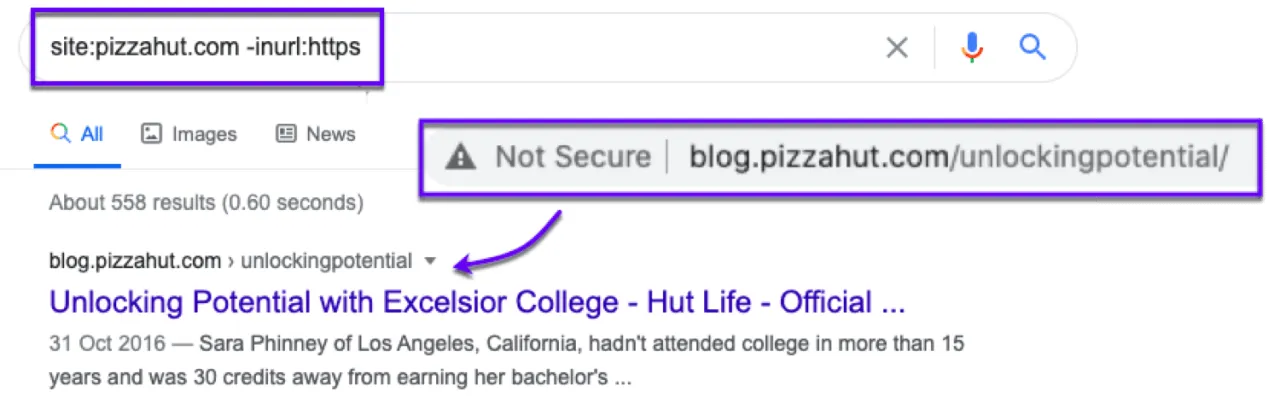

Problemy z konfiguracją URL: HTTP/HTTPS, www/bez www

To klasyczny błąd techniczny, który widzę bardzo często. Jeśli Twoja strona jest dostępna zarówno pod adresem http://twojadomena.pl, jak i https://twojadomena.pl, a do tego jeszcze pod http://www.twojadomena.pl i https://www.twojadomena.pl, to dla Google są to cztery różne adresy URL prowadzące do tej samej treści. Bez prawidłowej konfiguracji (np. przekierowań 301), wyszukiwarka nie wie, która wersja jest tą właściwą, co prowadzi do rozproszenia autorytetu i problemów z indeksowaniem. Zawsze upewnij się, że Twoja strona jest dostępna tylko pod jednym, preferowanym adresem URL (np. wyłącznie HTTPS z www).

Blogi: Paginacja, tagi i kategorie

Właściciele blogów często nieświadomie generują duplikaty poprzez nieprawidłowe zarządzanie paginacją, tagami i kategoriami. Strony paginacji (np. /blog/strona/2/) mogą zawierać powielone fragmenty treści z poprzednich stron. Podobnie, strony kategorii i tagów, jeśli nie są odpowiednio zoptymalizowane i zawierają tylko fragmenty artykułów, mogą być postrzegane jako duplikaty. Jeśli nie zadbasz o unikalne opisy dla każdej kategorii i tagu, a także o odpowiednie zarządzanie indeksowaniem tych stron, możesz niepotrzebnie marnować budżet na indeksowanie i rozpraszać autorytet linków na setki niemal identycznych URL-i.

Zdiagnozowałem problem: Co dalej? Skuteczne metody eliminacji duplicate content

Wykrycie duplikatów to dopiero połowa sukcesu. Teraz musimy je skutecznie wyeliminować lub wskazać Google, która wersja jest tą preferowaną. Na szczęście, mamy do dyspozycji kilka sprawdzonych metod.

Przekierowania 301 trwałe rozwiązanie

Przekierowania 301 to najsilniejsza i najbardziej trwała metoda konsolidacji mocy SEO. Stosujemy je, gdy chcemy trwale przenieść autorytet z jednego adresu URL na inny. Jeśli masz dwie lub więcej stron z identyczną treścią, a jedna z nich jest wyraźnie ważniejsza (np. starsza, z większą liczbą linków), powinieneś przekierować pozostałe na tę kanoniczną wersję. Przekierowanie 301 informuje wyszukiwarki, że strona została przeniesiona na stałe i przekazuje około 90-99% autorytetu linków. To idealne rozwiązanie w przypadku problemów z HTTP/HTTPS, www/bez www, a także dla starych, nieaktualnych URL-i, które mają swoje duplikaty.

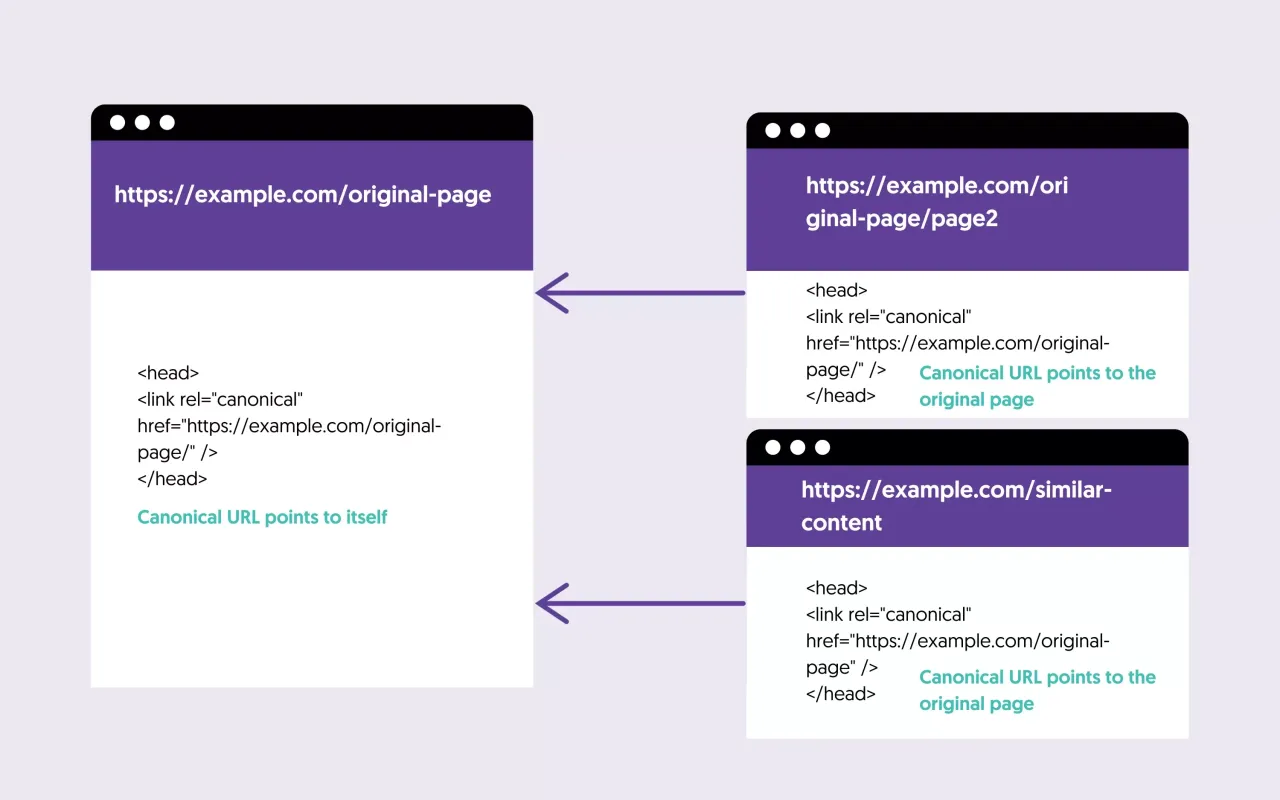

Tag kanoniczny (`rel="canonical"`) wskazanie preferowanej wersji

Tag kanoniczny (`rel="canonical"`) to meta tag umieszczany w sekcji `

` strony. Służy do wskazywania wyszukiwarkom, która wersja strony jest tą preferowaną, gdy kilka adresów URL zawiera tę samą lub bardzo podobną treść. Jest to szczególnie przydatne w sytuacjach, gdy nie możemy lub nie chcemy stosować przekierowania 301, np. w przypadku stron z filtrami, paginacją, wariantami produktów czy treści syndykowanych. Tag `rel="canonical"` mówi Google: "Ta strona jest kopią lub wariantem innej strony, a jej oryginalna/preferowana wersja znajduje się pod tym adresem...". Pamiętaj, że jest to sugestia dla Google, a nie bezwzględny nakaz, ale w większości przypadków jest skutecznie respektowana.

Meta tag `noindex` blokowanie indeksowania

Meta tag `noindex` to instrukcja dla robotów wyszukiwarek, aby nie indeksowały danej strony i nie wyświetlały jej w wynikach wyszukiwania. Stosujemy go dla stron, które z jakiegoś powodu muszą istnieć na naszej witrynie, ale nie chcemy, aby Google je indeksowało, ponieważ są duplikatami lub po prostu nie wnoszą wartości dla użytkownika szukającego w Google. Przykładami takich stron mogą być: strony z wynikami filtrowania, wersje do druku, strony z podziękowaniami po złożeniu zamówienia, wewnętrzne strony logowania, czy niektóre strony z polityką prywatności, które nie mają być w wynikach wyszukiwania. Użycie `noindex` zapobiega marnowaniu budżetu na indeksowanie na nieistotne strony i eliminuje problem duplikacji.

Prewencja jest kluczem: Jak tworzyć unikalne treści i unikać duplikacji

Najlepszą strategią w walce z duplicate content jest prewencja. Zamiast leczyć, lepiej zapobiegać. Świadome podejście do tworzenia treści i zarządzania stroną pozwoli Ci uniknąć wielu problemów.

Unikalne opisy produktów w e-commerce

Jeśli prowadzisz sklep internetowy, tworzenie unikalnych opisów produktów jest absolutnie kluczowe. Zamiast kopiować gotowe teksty od producentów, zainwestuj czas (lub pieniądze) w stworzenie własnych, angażujących i oryginalnych opisów. Nie tylko pomoże to Twojemu SEO, ale także wyróżni Cię na tle konkurencji i zwiększy szanse na konwersję. Potraktuj to jako inwestycję w unikalność i wartość dla klienta.

- Skup się na korzyściach dla klienta, a nie tylko na cechach produktu.

- Używaj języka, który rezonuje z Twoją grupą docelową.

- Wplataj słowa kluczowe w naturalny sposób.

- Dodawaj własne zdjęcia i filmy, aby wzbogacić treść.

- Zachęcaj do zostawiania opinii, które również generują unikalną treść.

Strategie zarządzania treścią na blogu

Na blogach problemem bywa kanibalizacja słów kluczowych i powtórzenia treści. Aby tego uniknąć, warto wdrożyć przemyślaną strategię contentową:

- Planowanie treści: Zanim napiszesz nowy artykuł, sprawdź, czy nie masz już podobnego tematu na blogu. Jeśli tak, rozważ aktualizację istniejącego wpisu zamiast tworzenia nowego.

- Głębia tematyczna: Zamiast pisać wiele krótkich, powierzchownych artykułów na podobne tematy, skup się na tworzeniu kompleksowych, dogłębnych treści, które wyczerpują dany temat.

- Zarządzanie tagami i kategoriami: Upewnij się, że każda kategoria i tag ma unikalny opis. Zastanów się, czy wszystkie strony tagów i kategorii powinny być indeksowane. Czasem lepiej jest użyć `noindex` dla tych, które nie wnoszą wartości dla SEO.

Przeczytaj również: Content reviewer: Zarobki, wyzwania, przyszłość. Czy to praca dla Ciebie?

Regularny monitoring i audyty

Nawet najlepiej zoptymalizowana strona może z czasem zacząć generować duplikaty. Nowe funkcje, zmiany w strukturze URL, czy błędy wdrożeniowe mogą prowadzić do niechcianych powtórzeń. Dlatego tak ważne jest, aby wdrożyć proces cyklicznego sprawdzania duplikatów. Regularnie wykorzystuj omówione wcześniej narzędzia od prostych operatorów Google, przez GSC, po Screaming Frog czy Copyscape. Tylko stały monitoring pozwoli Ci szybko reagować na pojawiające się problemy i utrzymywać zdrowy profil SEO Twojej strony. Pamiętaj, że SEO to proces, a nie jednorazowe działanie.